¿Qué es la latencia de vídeo? La guía definitiva para los organismos de radiodifusión

La latencia del vídeo es uno de los principales aspectos de la retransmisión en directo por Internet. Se trata de una medida técnica que afecta a la experiencia de visualización de su flujo.

Hay varios componentes técnicos que contribuyen a la latencia de vídeo, por lo que la latencia de su flujo dependerá de la potencia de su

configuración de transmisión.

En este post, vamos a responder a todas tus preguntas sobre la latencia de vídeo. Empezaremos analizando qué es la latencia de vídeo en el contexto de la transmisión en directo antes de echar un vistazo a algunos aspectos más técnicos. Determinaremos qué afecta a la latencia del vídeo y cómo controlar la latencia de sus secuencias.

Índice

- ¿Qué es la latencia de vídeo?

- ¿Por qué importa la latencia?

- ¿Qué afecta a la latencia de vídeo?

- ¿Qué es una latencia media de vídeo?

- Cómo calcular la latencia de vídeo

- Cómo reducir la latencia del streaming

- Cómo reducir la latencia en el codificador

- Métricas de streaming relacionadas

- Latencia de vídeo en Dacast

- Reflexiones finales

¿Qué es la latencia de vídeo?

La latencia de vídeo es la medida del tiempo que tarda una señal de vídeo en viajar desde la fuente que está capturando el vídeo hasta el

usuario. La latencia depende de varios factores técnicos, por lo que varía en función de la configuración de streaming que tengas.

Esto no debe confundirse con el “retraso”, que es el lapso de tiempo intencionado entre la captura y la emisión de un vídeo. Se utiliza para sincronizar las fuentes de streaming y dar tiempo a los productores para implementar los elementos cinematográficos.

La latencia de vídeo es menos intencionada y más un subproducto de la configuración técnica del flujo. Lo único que puedes hacer es intentar reducirlo al máximo manteniendo la calidad del flujo para ofrecer a tus espectadores una experiencia de visualización en tiempo real.

¿Por qué importa la latencia?

La latencia es muy importante para los organismos de radiodifusión porque, en muchos casos, afecta a la experiencia del usuario. Esto es especialmente cierto para

retransmisiones en directo que se benefician de la sensación de realismo.

Digamos que estás retransmitiendo una ceremonia de graduación. El momento en que cada estudiante cruza el escenario marca un hito importante para él y su familia. Los seres queridos que ven la retransmisión desde casa creen que están viviendo ese momento especial en tiempo real, o al menos casi. Si su público sabe que su flujo va con retraso, la conexión parece menos real.

Muchos profesionales del sector del streaming sostienen que una latencia alta es perjudicial para el resultado de una transmisión, ya que cuanta más latencia haya, menos realista será la transmisión.

La latencia también es un factor importante en las videoconferencias. Plataformas como Zoom y Google Meets admiten latencia en tiempo real, lo que permite mantener conversaciones digitales que imitan las interacciones cara a cara. Sin latencia en tiempo real, el videochat no sería posible.

Pero si se retransmite un acontecimiento en el que se quiere que los espectadores vean lo que ocurre en tiempo real, hay que intentar reducir la latencia todo lo posible.

¿Qué afecta a la latencia de vídeo?

La latencia se ve afectada por diferentes factores que intervienen en la retransmisión en directo. Todo, desde la red de Internet hasta el anfitrión de la transmisión de vídeo en directo, provoca latencia.

Dicho esto, repasemos algunas cosas que contribuyen a la latencia de vídeo.

Conexión a Internet

Una conexión a Internet rápida y fiable es imprescindible para la retransmisión en directo. Si tu conexión a Internet no está a la altura, la latencia del vídeo aumentará. La velocidad de su red de Internet afectará directamente a la latencia del flujo.

La velocidad de Internet sugerida es el doble del

ancho de banda por lo que los vídeos de mayor resolución necesitan una conexión más rápida para mantener baja la latencia.

Puedes probar tu velocidad de Internet buscando “test de velocidad de Internet” en Google y haciendo clic en “Ejecutar test de velocidad” en el primer resultado.

Recomendamos utilizar una conexión Ethernet para obtener el Internet más rápido y fiable. WiFi y los datos celulares se pueden utilizar en las opciones de copia de seguridad, pero Ethernet es la opción preferida. Independientemente de la opción que elijas, deberías realizar una prueba de velocidad antes del streaming para asegurarte de que todo va bien.

Una de las razones es que los cables Ethernet tienen una latencia mucho menor que la que puede ofrecer el WiFi. Esta reducción de la latencia puede tener un gran impacto en la latencia global de tu vídeo.

Ajustes del codificador

Con el streaming en línea, un vídeo necesita ser codificado, transportado y descodificado. Aquí es donde se produce una gran parte de la latencia, por lo que es importante que los ajustes de tu codificador estén correctamente establecidos y configurados para agilizar este proceso.

Aunque no hay una combinación mágica de ajustes del codificador que funcione para una transmisión de baja latencia en todos los casos, es importante consultar con el host de transmisión de vídeo elegido para ver qué ajustes exigen o recomiendan.

Dacast, por ejemplo, exige que las emisoras utilicen un códec H.264 o x264, una frecuencia de imagen de 25 o 30, un intervalo de frecuencia de imagen de 2 segundos y barrido progresivo. Para tener una mejor idea de la configuración óptima del codificador para reducir la latencia de vídeo, recomendamos consultar nuestra guía completa sobre

configuraciones de ajuste del codificador .

Protocolos de vídeo

Los protocolos de vídeo desempeñan un papel fundamental en la latencia. Los distintos protocolos de transmisión son capaces de transmitir con distintos niveles de latencia.

Actualmente, el protocolo óptimo para el streaming de baja latencia es HTTPS Live Streaming (HLS) para la entrega y Protocolo de mensajería en tiempo real (RTMP) para la ingesta. HLS es el protocolo más extendido para el streaming, ya que es compatible con el reproductor de vídeo HTML5. Sin embargo, el La ingesta RTMP reduce significativamente la latencia.

La entrega HLS con ingesta HLS es posible, pero no soporta streaming de baja latencia como lo hace la combinación de entrega HLS/ingesta RTMP.

Transporte seguro y fiable (SRT) es un innovador protocolo de transmisión de vídeo de Haivision. Este protocolo es conocido por su transmisión segura y de baja latencia. Por desgracia, la retransmisión SRT es relativamente nueva, por lo que la mayoría de las plataformas modernas de retransmisión en directo y la tecnología relacionada aún no se han subido al tren de la retransmisión SRT. Sin embargo, una vez que este protocolo esté más extendido, reducirá la latencia de vídeo de forma generalizada.

Otra tecnología más reciente creada para reducir la latencia de vídeo es

WebRTC . WebRTC es un proyecto de streaming de código abierto diseñado para permitir el streaming con latencia en tiempo real. Se diseñó específicamente pensando en las videoconferencias. Este proyecto lo utilizan actualmente las principales plataformas de videoconferencia, pero podría ayudar también a las plataformas de transmisión de vídeo en directo a reducir su latencia.

¿Qué es una latencia media de vídeo?

La latencia media de un flujo de vídeo en línea es de

seis segundos lo que se considera una latencia baja.

Dicho esto, he aquí un desglose de algunas categorías comunes de latencia.

| Tipo de latencia | Cantidad de latencia |

| Latencia de emisión estándar | 5-18 segundos |

| Baja latencia | 1-5 segundos |

| Latencia ultrabaja | Menos de 1 segundo |

| Latencia en tiempo real | Imperceptible para los usuarios |

Tanto la televisión tradicional como algunas transmisiones OTT entran en la categoría de latencia de emisión estándar. La televisión tradicional suele durar más de 18 segundos, y el streaming OTT. Algunas retransmisiones OTT entran en la categoría de baja latencia.

La latencia en tiempo real se utiliza para videoconferencias en plataformas de comunicación como Zoom, Facetime, Google Meets y otras herramientas de videochat.

Cómo medir la latencia de vídeo

Dado que la latencia afecta a la experiencia de los espectadores, es importante saber de qué es capaz tu configuración de streaming.

Medir la latencia puede ser un poco difícil. La forma más precisa de medir la latencia de vídeo es añadir una marca de tiempo al vídeo y hacer que alguien vea la transmisión en directo. Dígales que comuniquen la hora exacta en que aparece el fotograma con la hora impresa en su pantalla. Resta la hora de la marca de tiempo de la hora a la que el espectador vio el fotograma, y esa es tu latencia.

Si no sabes cómo poner un sello de tiempo a tu transmisión, también puedes pedirle a alguien que vea tu transmisión y le diga que grabe cuando llegue una entrada específica. Si se toma el tiempo de ejecución de la señal y se resta del tiempo de visualización de la señal, se obtiene la latencia.

El segundo método es menos preciso, ya que hay más margen de error, pero te dará una idea suficientemente buena de la latencia de tu configuración.

Cómo reducir la latencia del streaming

Los organismos de radiodifusión pueden reducir la latencia de varias maneras. Dado que la latencia viene determinada por varios componentes, los organismos de radiodifusión deben adoptar un enfoque holístico para reducir la latencia de sus flujos.

En primer lugar, querrás asegurarte de que estás transmitiendo con una

conexión rápida a Internet. Como hemos mencionado, es importante tener una velocidad de Internet constante del doble del ancho de banda que piensas utilizar en tu transmisión. También es importante ceñirse a los cables Ethernet en la medida de lo posible. No optes por WiFi o datos a menos que sea absolutamente necesario.

Mientras trabajas para reducir la latencia, asegúrate de que no estás perjudicando la calidad de tu flujo. Por supuesto, es posible que haya un poco de compensación entre calidad y latencia, pero asegúrate de que las configuraciones de tu codificador sigan produciendo una imagen de vídeo nítida.

Cómo reducir la latencia en el codificador

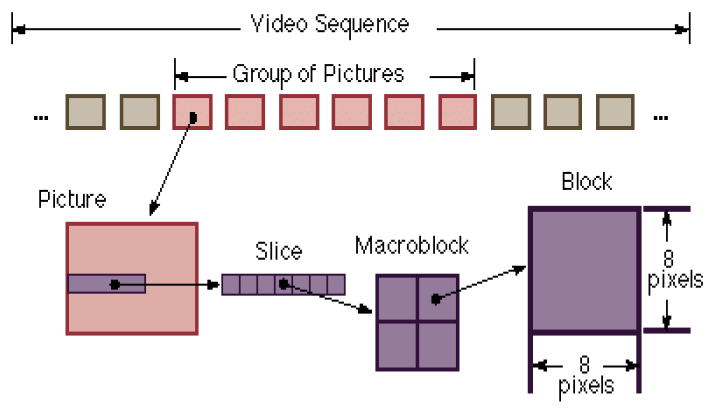

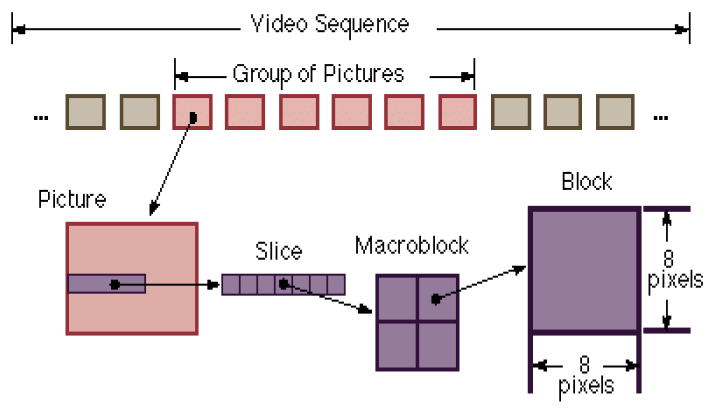

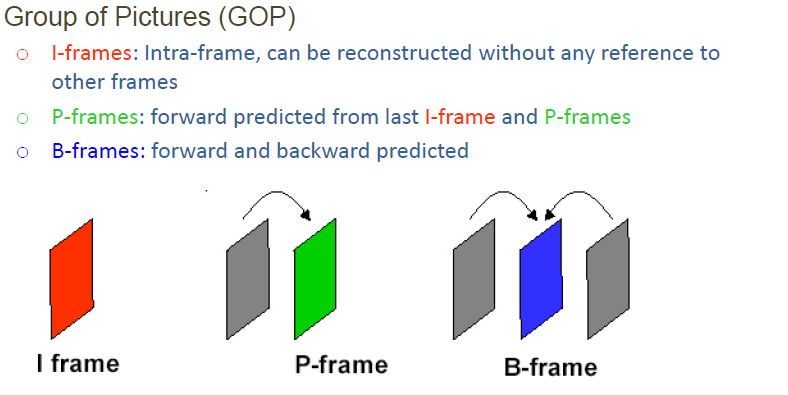

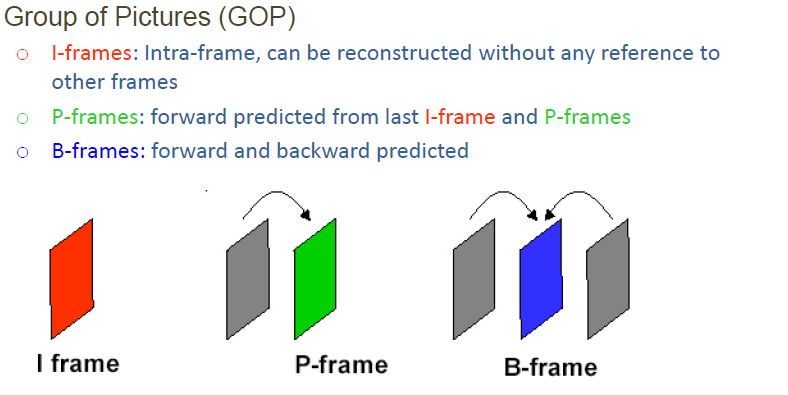

¿Cómo puede reducirse la latencia

nivel del codificador? El vídeo se comprime mediante técnicas basadas en fotogramas o en subfotogramas, normalmente “trozos”. Un flujo de vídeo se compone de fotogramas individuales. Un marco es un cuadro entero. Véase el esquema 1.

La trama A se compone de varias porciones, por lo que si se puede codificar por porciones se puede reducir la latencia del codificador, ya que no hay que esperar a la trama completa antes de transmitir la información.

Estos codificadores tienen latencias inferiores a un fotograma, algunos tan bajas como 10 – 30 milisegundos. Un codificador basado en fotogramas suele tener una latencia de entre 100 y 200 milisegundos.

También es posible reducir la latencia eliminando las tramas bidireccionales. Los fotogramas B tienen que esperar a un fotograma futuro para comprimir el vídeo. Esto aumenta la eficacia del codificador, pero también la latencia.

Si se eliminan los fotogramas B, hay que aumentar la tasa de bits para conseguir el mismo nivel de calidad de vídeo, un precio que muchos están dispuestos a pagar por reducir la latencia.

Métricas de streaming relacionadas

El rendimiento y el ancho de banda son dos componentes técnicos de la retransmisión en directo que van de la mano de la latencia. Hemos tratado brevemente cada una de estas métricas a lo largo de este artículo, pero para entender su relación a un nivel más técnico, lo mejor es compararlas una al lado de la otra.

Para refrescar la memoria, el ancho de banda es la medida de los datos transferidos en el flujo de vídeo, y el rendimiento es la cantidad de datos que se transfieren en un tiempo determinado.

Cuando se considera la relación entre

latencia, rendimiento y ancho de banda puedes imaginarte coches viajando a través de un túnel. Sólo pueden pasar un número limitado de coches a la vez sin provocar atascos.

En este escenario, el ancho de banda es la anchura del túnel, el rendimiento es el número de coches que lo atraviesan y la latencia es el tiempo que tardan los coches en atravesarlo. Para reducir la latencia, la configuración de streaming debe tener la potencia adecuada para el tamaño del archivo que se está enviando.

Latencia de vídeo en Dacast

Como ya hemos explicado, la latencia de vídeo tiene mucho que ver con el host de streaming de vídeo que utilices. Los streams en Dacast tienen un

latencia de sólo 12 a 15 segundos lo que se considera un flujo de baja latencia.

Este nivel de latencia se consigue mediante la combinación de entrega HLS e ingesta RTMP. Los usuarios de Dacast también pueden utilizar la ingesta HLS, pero la latencia no es tan baja con este enfoque.

Dacast también admite la transmisión de conferencias web a través de una integración de Zoom para una transmisión de latencia aún más baja.

Visita nuestra base de conocimientos para consultar nuestra guía dedicada a la

configurar un canal de streaming de baja latencia en Dacast.

PREGUNTAS FRECUENTES

1. ¿Cuál es una buena latencia para vídeo?

Una buena latencia para el streaming de vídeo es de unos seis segundos. Todo lo que sea menos que eso es aún mejor y tiende a ofrecer a los espectadores una experiencia de visualización casi en tiempo real. Dicho esto, la latencia estándar de difusión de vídeos oscila entre 5 y 18 segundos. Con Dacast, puede alcanzar fácilmente esa latencia de 12 a 15 segundos.

2. ¿Cómo puedo reducir la latencia de vídeo?

Hay dos formas principales de reducir la latencia de tus vídeos. En primer lugar, pon en orden tu velocidad de Internet. Utiliza una conexión a Internet rápida y fiable para garantizar que el flujo se carga rápidamente y con la mejor calidad posible.

Además, puede reducir la latencia en el nivel del codificador acelerando el proceso de codificación. En esta fase, puedes optar por mantener la calidad o sacrificar algo de calidad para mejorar la latencia: tú eliges.

3. ¿Cuáles son las causas de la latencia de vídeo?

El tiempo que tarda un archivo de vídeo en llegar desde su origen hasta el dispositivo del espectador es lo que causa la latencia. El vídeo pasa por un codificador, luego se retransmite a la CDN, de la CDN al dispositivo del espectador y, por último, se descodifica. Este proceso requiere una gran cantidad de tiempo y provoca latencia en el flujo.

4. ¿Cuánta latencia de vídeo se nota?

La latencia de vídeo sólo se nota cuando supera los 100 ms. Llegados a este punto, puede empezar a notarse un desfase entre el evento real y la retransmisión en directo. Dicho esto, si estás actuando, es posible que empieces a notar la latencia a partir de los 10 ms.

5. ¿Qué es la latencia de un vídeo?

En términos sencillos, la latencia de vídeo es el tiempo que tarda el vídeo en viajar desde su origen (la cámara) hasta el destino (el dispositivo del espectador). Este tiempo suele representarse en milisegundos y puede llegar hasta los 18 segundos para una emisión normal. Una latencia más baja es deseable para una experiencia de visualización casi en tiempo real.

Reflexiones finales

Como radiodifusor, es importante conocer bien la latencia. Saber cómo funciona la latencia y cómo puedes controlar la latencia de tu configuración de streaming te dará más poder sobre el resultado de tu transmisión.

¿Está buscando una

plataforma de streaming en directo de baja latencia para streaming profesional? Dacast podría ser la opción para usted. Nuestra plataforma de vídeo en línea incluye una serie de funciones que permiten el streaming a nivel profesional, como un reproductor de vídeo HTML5 para todos los dispositivos, análisis avanzados, una API de vídeo, una plataforma de streaming de marca blanca y la ingesta y reproducción RTMP, así como asistencia al cliente 24 horas al día, 7 días a la semana.

Puede probar Dacast sin riesgos durante 14 días con nuestra prueba gratuita. Inscríbete hoy mismo para empezar a retransmitir. No se requiere tarjeta de crédito ni contratos vinculantes.

Para recibir regularmente consejos sobre retransmisiones en directo y ofertas exclusivas, puede unirse al grupo Dacast en LinkedIn.

Tenga en cuenta que este post fue escrito originalmente por Mike Galli, CEO de Niagara Video. Fue revisado en 2021 por Emily Krings para incluir la información más actualizada. Emily es redactora de contenidos estratégicos y narradora. Está especializada en ayudar a las empresas a crear contenidos de blog que conecten con su audiencia.

Conexión

Conexión Eventos

Eventos Business

Business Organizaciones

Organizaciones Entretenimiento y Medios de Comunicación

Entretenimiento y Medios de Comunicación API

API Herramientas

Herramientas Centro de Aprendizaje

Centro de Aprendizaje Soporte

Soporte Artículos de Apoyo

Artículos de Apoyo Dacast

Dacast